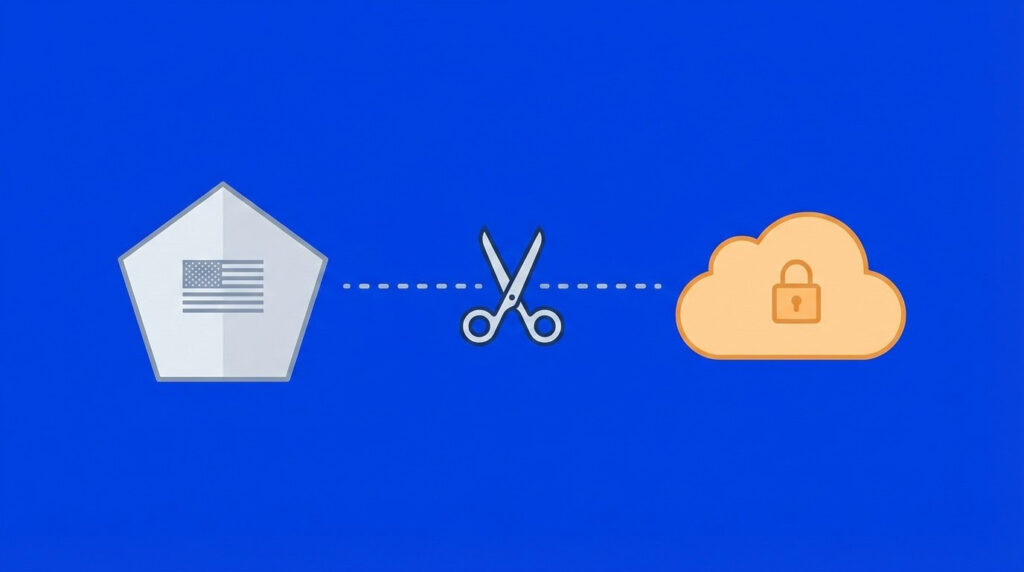

La relación entre Empresas de IA y el ejército estadounidense está entrando en una nueva fase tensa. En el centro de la tormenta está antrópicola startup con sede en San Francisco conocida por su enfoque en “seguridad de la IA”. Según un informe reciente por Axiosel Pentágono amenaza actualmente con romper su asociación de 200 millones de dólares con Anthropic por un desacuerdo clave: cuánto control debería tener una empresa privada sobre cómo el ejército usa su software, como Modelos de IA de Claude.

El ultimátum de 200 millones de dólares: por qué el Pentágono amenaza con deshacerse del acuerdo de Anthropic AI

Durante meses, el Departamento de Defensa (DoD) ha estado presionando a cuatro importantes actores de la IA (Anthropic, OpenAI, Google y xAI) para que permitan que los militares utilicen sus modelos para «todos los fines legales». Básicamente, esto significa levantar las barreras estándar que impiden que los usuarios comunes apliquen IA en áreas sensibles como el desarrollo de armas, la recopilación de inteligencia o las operaciones en el campo de batalla.

Los informes sugieren que OpenAI, Google y xAI han mostrado cierto grado de flexibilidad. Antrópico, por otro lado, es el más resistente. La compañía ha trazado una línea dura en dos límites específicos: el uso de su modelo Claude para la vigilancia masiva de estadounidenses y el desarrollo de armamento totalmente autónomo: sistemas que pueden disparar sin un ser humano en el circuito.

Tensiones tras el ataque de Maduro

La fricción alcanzó un punto de ebullición tras la operación militar estadounidense para capturar al expresidente venezolano Nicolás Maduro. El Wall Street Journal informó que el Pentágono utilizó a Claude durante la misión a través de una asociación con la firma de datos Palantir. Este incidente generó preguntas internas en Anthropic.

Los funcionarios de defensa expresaron su frustración cuando Anthropic supuestamente preguntó si sus tecnología estuvo involucrado en la redada, donde ocurrió “fuego cinético” (combate). El Pentágono considera que este tipo de supervisión es inviable. La entidad argumenta que los combatientes no pueden detenerse a negociar casos de uso individuales con un proveedor de software durante las operaciones activas.

Un choque cultural

La disputa pone de relieve un importante choque cultural. Los funcionarios citados por Axios han descrito a Anthropic como el más «ideológico» de los laboratorios de IA. Según se informa, la empresa se rige por una estricta política de uso interno que incluso provoca “inquietud interna” entre sus propios ingenieros con respecto al trabajo militar. Sin embargo, el Pentágono se enfrenta a un dilema: a pesar de las fricciones, los funcionarios admiten que Claude está actualmente por delante de sus competidores en aplicaciones gubernamentales especializadas y clasificadas.

Si las dos partes no pueden llegar a un acuerdo, el Pentágono ha sugerido que podría etiquetar a Anthropic como un «riesgo para la cadena de suministro». También podría buscar un reemplazo ordenado. Por su parte, Anthropic sostiene que está comprometida con la seguridad nacional. La firma de IA señala que fue la primera empresa en poner modelos en redes clasificadas. Por ahora, ambas partes siguen hablando.

Fuente: Android Headlines